Dans cet article, on voit en détail les avantages de la librairie XGBoost, comment l’utiliser, et pourquoi les experts l’apprécient !

XGBoost est une librairie permettant d’entraîner des algorithme de Gradient Boosting.

Elle permet d’avoir les mêmes types de résultats qu’avec la librairie sklearn mais… beaucoup plus rapidement !

Son efficacité et sa rapidité la rend très populaire aux yeux des experts !

XGBoost est largement utilisé par les professionnels dans divers domaines, notamment le Machine Learning, la Data Science et la finance.

C’est une librairie puissante pour entraîner des algorithmes de Gradient Boosting.

Rentrons dans le détails !

Qu’est-ce que XGBoost ?

XGBoost (XGB) veut dire « eXtreme Gradient Boosting ».

C’est une bibliothèque permettant d’entraîner des algorithmes de Gradient Boosting.

Un type d’algorithme qu’on a aborder dans notre article sur les méthodes d’ensemble.

Pour faire simple les méthodes d’ensemble permettent d’utiliser plusieurs algorithmes de Machine Learning en même temps !

Pourquoi faire ça ?

Car cela nous donne un résultat beaucoup plus pertinent que si l’on se fit à un seul algorithme.

Le Gradient Boosting consiste à entraîner une série de modèles. Chaque modèle est entraîné dans le but de corriger les erreurs du modèle précédent. La prédiction finale est faite en combinant les prédictions de tous les modèles de la série.

Dans le cas de XGB, les modèles entraînés sont des Arbres de Décision.

La librairie est particulièrement utile car elle peut gérer facilement de grands datasets ainsi que des modèles complexes.

En plus de cela, elle possède de nombreuses fonctions avancées qui te permetteront d’affiner l’entraînement de tes modèles.

Comment utiliser XGBoost en Python

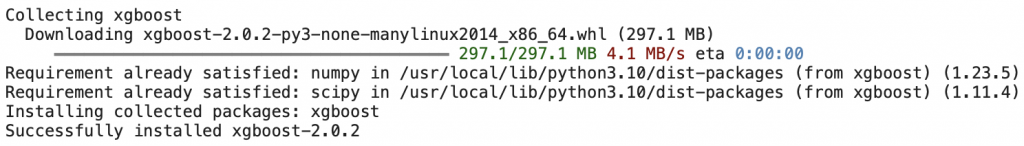

Pour utiliser XGBoost en Python, tu dois d’abord installer la bibliothèque.

Tu peux l’installer en utilisant la commande pip :

!pip install xgboost

Une fois que tu as installé la librairie, importe-la dans ton code Python :

import xgboost as xgbOk maintenant, on considère que tu as déjà tes données X_train, y_train, X_test et y_test.

Pour entraîner un modèle XGB sur ces données, tu dois les convertir dans un format que XGB peut interpréter : le format xgb.DMatrix.

Pour cela, on utilise simplement la fonction DMatrix() :

import xgboost as xgb

dtrain = xgb.DMatrix(X_train, label=y_train)

dtest = xgb.DMatrix(X_test, label=y_test)On peut ensuite indiquer les hyperparamètres de notre modèle :

param = {'objective': 'binary:logistic', 'eval_metric': 'error'}Et finalement lancer l’entraînement :

model = xgb.train(param, dtrain, num_boost_round=10)Tu peux trouver la liste des hyperparamètres pour les modèles XGB sur la documentation officielle.

Pour lancer une prédiction, on utilise simplement la fonction predict() sur nos données de test :

model.predict(dtest)Et finalement, on peut calculer la précision de notre modèle comme suit :

accuracy = sum(predictions == y_test) / len(y_test)

print('Accuracy: ', accuracy)Alors ? Efficace ?

Au fait, si ton objectif est d'apprendre le Deep Learning - j’ai préparé pour toi le Plan d’action pour Maîtriser les Réseaux de neurones.

7 jours de conseils gratuits d’un ingénieur spécialisé en Intelligence Artificielle pour apprendre à maîtriser les réseaux de neurones à partir de zéro :

- Planifie ton apprentissage

- Structure tes projets

- Développe tes algorithmes d’Intelligence Artificielle

J’ai basé ce programme sur des faits scientifiques, des approches éprouvées par des chercheurs mais également mes propres techniques que j'ai conçues au fil de mes expériences dans le domaine du Deep Learning.

Pour y accéder, clique ici :

À présent, on peut revenir à ce que je mentionnais précédemment.

Donne moi ta réponse en commentaire 💥

Comment les experts utilisent XGBoost ?

Les experts en Machine Learning utilisent souvent XGB pour entraîner des modèles complexes pour une variété de tâches, telles que la classification, la régression et le ranking.

Ils peuvent l’utiliser seul ou dans le cadre d’un pipeline de Machine Learning plus important.

Mais l’un des principaux avantages de XGB est qu’il est hautement customizable.

Les experts peuvent modifier un large éventail d’hyperparamètres pour affiner le processus d’entraînement et améliorer les performances du modèle.

Ils peuvent également utiliser des fonctions avancées telles que le multi-threading et l’entraînement distribuée pour accélérer davantage l’entraînement du modèle.

Les experts utilise aussi XGB dans le cadre de modèle d’ensemble.

L’algorithme de XGB est ainsi combiné aux prédictions d’autres modèles pour obtenir une prédiction finale.

XGB étant déjà un modèle d’ensemble, on a ainsi un ensemble d’ensemble.

Les poupées russes du Machine Learning🪆

Évidemment cela conduit souvent à une amélioration des performances.

Conseils et astuces pour utiliser XGBoost

Voici quelques conseils et astuces que tu peux utiliser pour améliorer les performances de tes modèles XGBoost :

- Hyperparameter Tuning : modifie les hyperparamètres en utilisant la grid search ou la random search.

- Early Stopping : utilise l’early stopping pour éviter l’overfitting et trouver le nombre optimal d’epoch.

- Learning Rate : essaye un learning rate plus élevé, mais garde à l’esprit que cela peut augmenter le risque d’overfitting.

- Nombre d’estimateur : utilise un plus grand nombre d’estimateurs (Arbre de Décision), mais attention, cela peut augmenter la durée d’entraînement.

- Plus de données : utilise plus de données.

Précédemment, on a écrit un article sur la librairie LightGBM.

Elle aussi est une librairie de Gradient Boosting.

Tu peux te demander qu’elle est la différence entre ces deux librairies…

Voilà la réponse 😉

Difference avec LightGBM

XGB et LightGBM sont deux bibliothèques populaires pour l’entraînement d’algorithme de Gradient Boosting.

Elles sont toutes deux open-source et sont utilisées dans une variété de tâches de Machine Learning.

Mais il existe quelques différences essentielles entre XGB et LightGBM :

- Durée d’apprentissage : LightGBM est généralement plus rapide que XGB pour l’entraînement sur de grands dataset. Ceci est dû au fait que LightGBM utilise un algorithme plus efficace pour entraîner les arbres. Voir l’algorithme « leaf-wise » pour plus d’infos.

- Utilisation de la mémoire : LightGBM utilise moins de mémoire que XGB.

- Traitement des valeurs manquantes : LightGBM peut gérer les valeurs manquantes dans le dataset plus efficacement que XGB grâce à l’utilisation d’algorithmes basés sur les histogrammes. Voir la technique « Gradient-based One-Side Sampling » (GOSS) pour plus d’infos.

- Traitement des variables catégorielles : LightGBM est capable de gérer les variables catégorielles plus efficacement que XGB grâce, là aussi, à l’utilisation d’algorithmes basés sur les histogrammes. Voir la technique « Exclusive Feature Bundling » (EFB) pour plus d’infos.

Une bonne approche consiste à essayer les deux librairie et de voir laquelle fonctionne le mieux pour ton problème particulier.

On parle en détail des algorithmes basés sur les histogrammes dans notre article de présentation de LightGBM.

Un article à lire pour les plus expérimentés d’entre vous ou simplement pour les curieux qui veulent utiliser LightGBM !

À bientôt sur Inside Machine Learning ! Ciao 🍕

Un dernier mot, si tu veux aller plus loin et apprendre le Deep Learning - j’ai préparé pour toi le Plan d’action pour Maîtriser les Réseaux de neurones.

7 jours de conseils gratuits d’un ingénieur spécialisé en Intelligence Artificielle pour apprendre à maîtriser les réseaux de neurones à partir de zéro :

- Planifie ton apprentissage

- Structure tes projets

- Développe tes algorithmes d’Intelligence Artificielle

J’ai basé ce programme sur des faits scientifiques, des approches éprouvées par des chercheurs mais également mes propres techniques que j'ai conçues au fil de mes expériences dans le domaine du Deep Learning.

Pour y accéder, clique ici :